توهم مدلهای زبانی بزرگ (Hallucination) یکی از چالشهای مهم در توسعه و استفاده از این مدلها است. این پدیده زمانی رخ میدهد که مدلهای زبانی اطلاعات نادرست، غیرواقعی یا بیاساس تولید میکنند. با وجود پیشرفتهای چشمگیر در حوزه هوش مصنوعی و بهویژه مدلهای زبانی بزرگ مانند GPT-4، توهم LLMs نشاندهنده محدودیتهایی است که هنوز در زمینه درک و تولید زبان طبیعی وجود دارد.

مشکل توهم مدلهای زبانی بزرگ (Hallucination) به علت گرایش این مدل ها به ساختن است. مدلهای زبانی بزرگ به قدری در کار خود خوب هستند که معمولاً نتایج آنها درست به نظر میرسد و این اعتماد به آنها را سخت میکند.

این گرایش به ساختن چیزها که به عنوان توهم شناخته میشود، یکی از بزرگترین موانع پیشرفت چتباتها و استفاده گستردهتر از آنها است. چرا توهم LLMs اتفاق میافتد؟ و چرا نمیتوانیم آن را برطرف کنیم؟

اگر مایلید در مورد توهم هوش مصنوعی یا هالوسیناسیون بیشتر بدانید، پیشنهاد می کنم مطلب زیر را مطالعه بفرمائید:

چرا توهم مدل های زبانی اتفاق می افتد؟

برای درک اینکه چرا توهم مدلهای زبانی بزرگ ایجاد می شود، باید ببینیم که چگونه کار میکنند. اولین نکتهای که باید توجه داشت این است که مدلها طراحی شدهاند تا چیزهایی را بسازند. وقتی از یک چتبات سوالی میپرسید، از مدل زبانی بزرگی که آن را پشتیبانی میکند، پاسخ خود را میگیرد. اما این شبیه به جستجوی اطلاعات در یک پایگاه داده یا استفاده از موتور جستجو در وب نیست.

اگر به یک مدل زبانی بزرگ نگاهی بیندازید، اطلاعات آمادهای برای بازیابی نمیبینید. در عوض، میلیاردها و میلیاردها عدد پیدا میکنید. این مدل ها ، از این اعداد برای محاسبه پاسخهای خود از ابتدا استفاده میکند و به صورت لحظهای توالیهای جدیدی از کلمات تولید میکند.

بسیاری از متونی که یک مدل زبانی بزرگ تولید میکند، به نظر میرسد که از یک پایگاه داده یا یک صفحه وب واقعی کپی شده است. اما همانند بیشتر آثار داستانی، این شباهتها تصادفی هستند. یک مدل زبانی بزرگ بیشتر شبیه به یک توپ جادویی ∞ بینهایت است تا یک دانشنامه.

پیشبینی کلمات بعدی در مدل های زبانی بزرگ(LLMs)

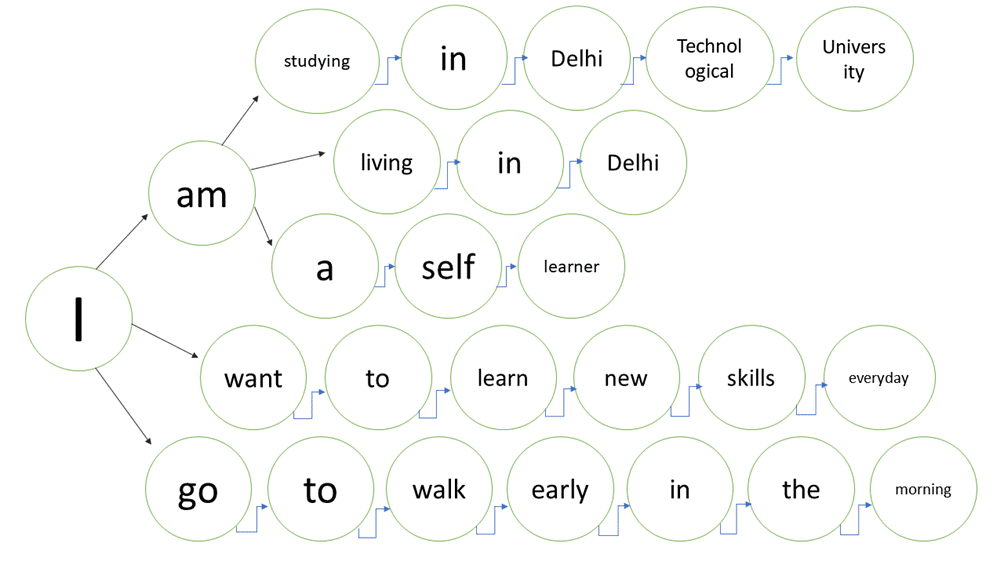

مدلهای زبانی بزرگ متنها را با پیشبینی کلمه بعدی در یک توالی تولید میکنند. اگر مدلی “the cat sat” را ببیند، ممکن است “on” را حدس بزند. آن توالی جدید دوباره به مدل داده میشود که ممکن است اکنون “the” را حدس بزند. دوباره این کار را تکرار کنید و ممکن است “mat” را حدس بزند و همینطور ادامه میدهد.

این یک ترفند کافی است تا تقریباً هر نوع متنی را که میتوانید به آن فکر کنید، از لیستهای آمازون گرفته تا داستانهای پر طرفدار، کدهای کامپیوتری و مقالات مجله ها و بسیاری موارد دیگر تولید کند. آندری کارپاتی، دانشمند کامپیوتر و یکی از بنیانگذاران OpenAI، می گوید: “مدلهای زبانی بزرگ یاد میگیرند که اسناد اینترنتی را در رویا ببینند”.

فکر کنید که میلیاردها عدد درون یک مدل زبانی بزرگ مانند یک صفحه گسترده وسیع است که احتمال آماری ظاهر شدن کلمات خاصی در کنار کلمات دیگر را ثبت میکند. وقتی مدل آموزش داده شد، مقادیر در صفحه گسترده تنظیم میشوند.

فرآیندی این مقادیر را بارها و بارها تنظیم میکند تا حدسهای مدل، با الگوهای زبانی که در ترابایتها متن گرفته شده از اینترنت یافت میشوند، مطابقت داشته باشد.برای حدس زدن یک کلمه، مدل به سادگی اعداد خود را اجرا میکند.

امتیازی برای هر کلمه در واژگان خود محاسبه میکند که نشان میدهد چقدر احتمال دارد آن کلمه بعدی در توالی جاری باشد. کلمهای که بهترین امتیاز را داشته باشد، برنده میشود. به طور خلاصه، مدلهای زبانی بزرگ ماشینهای آلات آماری هستند. دسته را بچرخانید و یک کلمه بیرون میآید.

همه چیز LLM توهم است

نکته اصلی چیست؟ به طور کلی همه چیز توهم است، اما ما فقط وقتی آن را توهم مینامیم که متوجه میشویم اشتباه است. آیا میتوانیم آنچه مدلهای زبانی بزرگ تولید میکنند را کنترل کنیم تا متنی تولید کنند که به طور قطعی صحیح باشد؟ این مدلها آنقدر پیچیده هستند که اعداد آنها را نمیتوان به صورت دستی دستکاری کرد. اما برخی محققان معتقدند که آموزش آنها بر روی متنهای بیشتر به کاهش نرخ خطای آنها کمک خواهد کرد. این روندی است که منجر به بزرگتر و بهتر شدن مدلهای زبانی می شود.

درخواست از مدلها برای بررسی کار خود به صورت مرحله به مرحله، رویکرد دیگری است که به عنوان زنجیرهای از تفکر شناخته میشود. تحقیقات نشان داده که این روش دقت خروجی یک چتبات را افزایش میدهد. در آینده ممکن است مدلهای زبانی بزرگ بتوانند متنهایی که تولید میکنند را بررسی کرده و وقتی شروع به منحرف شدن میکنند، به عقب برگردند.

اما هیچ یک از این تکنیکها به طور کامل توهمات را متوقف نخواهد کرد. تا زمانی که مدلهای زبانی بزرگ احتمالاتی باشند، در تولید آنها عنصری از شانس وجود دارد. اگر ۱۰۰ تاس را بیندازید هر باریک الگوی متفاوت خواهید داشت.

حتی اگر تاسها، مانند مدلهای زبانی بزرگ، طوری وزن شده باشند که برخی الگوها بسیار بیشتر از دیگران تولید شوند، نتایج همچنان هر بار یکسان نخواهند بود. وقتی در نظر بگیرید که این فناوری چند بار در روز استفاده میشود، حتی یک خطا در ۱,۰۰۰ یا ۱۰۰,۰۰۰، به تعداد زیادی خطا میانجامد.

هرچه این مدلها دقیقتر شوند، بیشتر اعتماد ما را جلب خواهند کرد. مطالعات نشان میدهند هرچه چتباتها بهتر شوند، زمانی که یک خطا اتفاق میافتد، بیشتر احتمال دارد افراد آن را نادیده بگیرند.

نمونه هایی از توهم مدل های زبانی بزرگ

چتبات جدید سازمان بهداشت جهانی برای ارائه بهترین خدمات در تاریخ ۲ آوریل راهاندازی شد.

آواتار مجازی جدید با پشتیبانی از GPT-3.5 به نام SARA (Smart AI Resource Assistant for Health) به صورت ۲۴ ساعته و در هشت زبان مختلف نکات بهداشتی درباره نحوه تغذیه مناسب، ترک سیگار، کاهش استرس و موارد دیگر را به میلیونها نفر در سراسر جهان ارائه میدهد.

اما مانند همه چتباتها، SARA نیز میتواند در پاسخهای خود اشتباه کند. به زودی مشخص شد که اطلاعات نادرستی ارائه میدهد. در یک مورد، لیستی از نامها و آدرسهای جعلی برای کلینیکهای غیرواقعی در سانفرانسیسکو ارائه کرد. سازمان بهداشت جهانی در وبسایت خود هشدار میدهد که SARA همیشه دقیق نیست.

این اتفاق دوباره تکرار شد. اشتباهات چتباتها اکنون به یک معضل جدی تبدیل شده است. چتبات علمی Meta با نام Galactica که مدت کوتاهی فعال بود، مقالات علمی جعلی ساخت و در ویکی پدیا درباره “تاریخ خرسها در فضا” مقاله تولید کرد. در ماه فوریه، کانادا مجبور شد سیاست بازپرداختی، که توسط چتبات خدمات مشتریانش اختراع شده بود را رعایت کند.

سال گذشته، یک وکیل به دلیل ارائه اسناد جعلی به دادگاه جریمه شد. این اسناد توسط ChatGPT ساخته شده بودند و پر از نظرات قضایی و ارجاعات قانونی جعلی بود. وکیل به قاضی گفته بود: “من درباره این سایت جدید شنیده بودم و به اشتباه تصور می کردم شبیه یک موتور جستجوی فوق العاده است. نمی دانستم که ChatGPT میتواند مواردی را ابداع کند.”

برای کاهش اثرات منفی توهم مدلهای زبانی بزرگ (Hallucination)، محققان بهدنبال روشهای بهبود الگوریتمهای آموزشی، ارزیابیهای انسانی و استفاده از منابع معتبر هستند.

شاید بهترین راه حل برای جلوگیری از توهم LLMs، مدیریت انتظارات ما درباره موارد استفاده این ابزارها، باشد.