هوش مصنوعی مولد، جعل، کلاهبرداری و داکسینگ را آسانتر از همیشه کرده است. استفاده خلافکاران از هوش مصنوعی ، جهش بزرگی در بهرهوری دنیای زیرزمینی خلافکاران ایجاد کرده است. هوش مصنوعی مولد یک جعبه ابزار جدید و قدرتمند فراهم میکند که به خلافکاران اجازه میدهد بسیار کارآمدتر و بین المللیتر از همیشه عمل کنند.

افزایش کارایی و بهرهوری خلافکاران

استفاده خلافکاران از هوش مصنوعی (AI) در دهههای اخیر به شدت افزایش یافته است. این فناوری با قابلیتهای پیشرفتهاش میتواند به آنها در انجام فعالیتهای غیرقانونی کمک کند. بیشتر خلافکاران در مخفیگاه تاریک زندگی نمیکنند و نقشه نمیکشند. بیشتر آنها افراد معمولی هستند که فعالیتهای معمولی دارند و نیاز به بهرهوری دارند.

سال گذشته شاهد ظهور و سقوط WormGPT بودیم. یک مدل زبانی هوش مصنوعی که بر اساس یک مدل منبع باز ساخته شده بود و بر روی دادههای مرتبط با بدافزار آموزش دیده بود. این مدل برای کمک به هکرها ایجاد شده بود و هیچ قاعده یا محدودیت اخلاقی نداشت.

اما سازندگان آن اعلام کردند که این مدل را پس از جلب توجه رسانهها تعطیل میکنند. از آن زمان، خلافکاران سایبری توسعه مدلهای هوش مصنوعی خود را متوقف کردهاند. در عوض، آنها به ترفندهایی روی آوردهاند که با ابزارهای موجود به طور قابل اعتمادی کار میکنند.

در ادامه ۵ روش استفاده خلافکاران از هوش مصنوعی شرح داده شده است:

فیشینگ : بزرگترین کاربرد هوش مصنوعی مولد در بین خلافکاران

فیشینگ تلاش برای فریب مردم به افشای اطلاعات حساس است که میتواند برای مقاصد مخرب استفاده شود. محققان دریافتهاند که با افزایش استفاده از چت بات ChatGPT، تعداد ایمیلهای فیشینگ نیز به شدت افزایش یافته است.

خدمات تولید اسپم، مانند GoMail Pro، چت بات ChatGPT را در خود ادغام کردهاند. این سرویس ها به کاربران خلافکار اجازه میدهد پیامهای ارسالی به قربانیان را ترجمه یا بهبود دهند.

سیاستهای OpenAI استفاده از محصولات آنها برای فعالیتهای غیرقانونی را ممنوع میکند. اما در عمل نظارت بر این موضوع دشوار است. زیرا بسیاری از درخواستهای به ظاهر بی ضرر نیز میتوانند برای مقاصد مخرب استفاده شوند.

OpenAI از ترکیب بازبینیهای انسانی و سیستمهای خودکار برای شناسایی و جلوگیری از سوءاستفاده از مدلهای خود استفاده میکند. در صورت نقض سیاستهای شرکت، هشدارها، تعلیق موقت و ممنوعیتها را صادر میکند.

سخنگوی OpenAI گفت: “ما ایمنی محصولات خود را جدی میگیریم و همواره در حال بهبود اقدامات ایمنی خود بر اساس نحوه استفاده مردم از محصولاتمان هستیم.” او افزود: “ما به طور مداوم در تلاشیم تا مدلهای خود را در برابر سوءاستفاده و فرار از محدودیتها، مقاومتر و ایمنتر کنیم، در حالی که همچنان مفید بودن و عملکرد وظیفهای آنها را حفظ میکنیم.”

قبلا تشخیص کلاهبردارانی که به انگلیسی مسلط نبودند نسبتاً آسان بود زیرا پیامهای انگلیسی آنها پر از اشتباهات گرامری بود. مدلهای زبانی به کلاهبرداران اجازه میدهند پیامهایی تولید کنند که شبیه چیزی باشد که یک گوینده بومی زبان نوشته است.

به لطف ترجمه بهتر توسط هوش مصنوعی، گروههای جنایی مختلف در سراسر جهان نیز میتوانند بهتر با یکدیگر ارتباط برقرار کنند. خطر این است که آنها میتوانند عملیاتهایی در مقیاس بزرگی را هماهنگ کنند که فراتر از مرزهای ملی آنها باشد و قربانیانی در کشورهای دیگر را هدف قرار دهند.

جعل صوتی دیپ فیک : استفاده خلافکاران از دیپ فیک برای کلاهبرداری

هوش مصنوعی مولد توسعه دیپ فیک را به طور قابل توجهی پیش برده است، به طوری که تصاویر، ویدیوها و صداهای مصنوعی، واقعیتر از همیشه به نظر میرسند. این موضوع از نظر خلافکاران پنهان نمانده است.

اوایل امسال، یک کارمند در هنگ کنگ به دلیل استفاده خلافکاران از دیپ فیک صدای مدیر مالی شرکت، برای متقاعد کردن او به انتقال ۲۵ میلیون دلار به حساب کلاهبرداران، قربانی شد.

دیپ فیکها در دنیای زیرزمینی بازاریابی میشوند و افرادی در پلتفرمهایی مانند تلگرام نمونه کار دیپ فیکهای خود را نشان میدهند و خدمات خود را میفروشند. یکی از محبوبترین افرادی که خلافکاران برای دیپ فیک استفاده میکنند، ایلان ماسک است.

ساخت ویدیوهای دیپ فیک همچنان پیچیده است و برای انسانها راحتتر قابل تشخیص است. ولی این مورد برای دیپ فیکهای صوتی صدق نمیکند. ساخت آنها ارزان است و تنها به چند ثانیه از صدای کسی نیاز دارد.

در ایالات متحده، مواردی گزارش شده که در آن مردم تماسهای نگران کنندهای از عزیزان خود دریافت کردهاند که میگفتند ربوده شدهاند و برای آزادی خود درخواست پول میکردند.

مردم باید آگاه باشند که اکنون این چیزها وجود دارد و ممکن است آنها را در موقعیتی بسیار استرسزا قرار دهند.

راههایی برای محافظت از این خطرات وجود دارد. مثلا بین عزیزان یک کلمه امن محرمانه و به طور منظم تغییر کننده، توافق شود که میتواند به تأیید هویت شخص در طرف دیگر خط کمک کند.

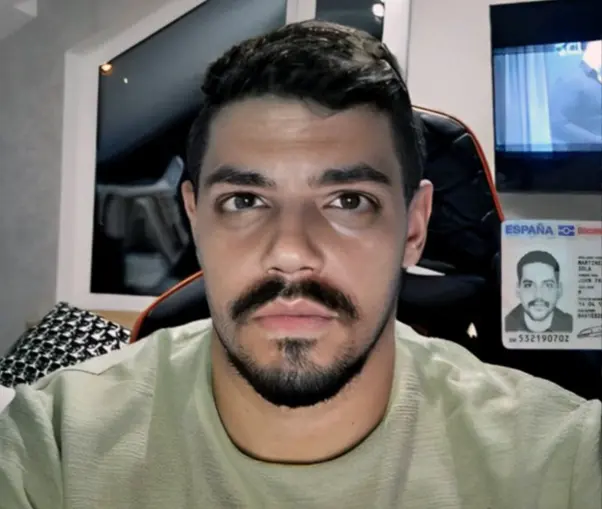

دور زدن بررسی های هویتی : استفاده از دیپ فیکها برای دور زدن سیستمهای تأیید هویت

خلافکاران از دیپ فیکها برای دور زدن سیستمهای تأیید هویت “مشتری خود را بشناسید” نیز استفاده میکنند. بانکها و صرافیهای ارزهای دیجیتال از این سیستمها برای تأیید اینکه مشتریان آنها افراد واقعی هستند استفاده میکنند.

آنها از کاربران جدید میخواهند در حالی که یک سند هویتی فیزیکی را در مقابل دوربین نگه داشتهاند، یک از خودشان عکس بگیرند. اما خلافکاران شروع به فروش اپلیکیشنهایی در پلتفرمهایی مانند تلگرام کردهاند که به افراد اجازه میدهد این الزام را دور بزنند.

این اپلیکیشنها با ارائه یک شناسه جعلی یا دزدیده شده و اعمال تصویر دیپ فیک بر روی صورت شخص واقعی، برای فریب دادن سیستم تأیید هویت در دوربین گوشی اندرویدی کار میکنند.

تکنیکهایی که استفاده می شود شبیه به فیلترهای اینستاگرام است که در آن صورت شخص دیگری جایگزین صورت شما میشود.مهندسان باید در آینده احراز هویتهای پیچیدهتری را پیاده سازی کنند.

خدمات جیلبریک (jailbreak) : استفاده از جیلبریک به عنوان یک خدمت توسط خلافکاران

اگر از اکثر سیستمهای هوش مصنوعی بپرسید که چگونه یک بمب بسازید، پاسخی مفید دریافت نخواهید کرد. دلیل آن این است که شرکتهای هوش مصنوعی تدابیر مختلفی برای جلوگیری از ارائه اطلاعات مضر یا خطرناک توسط مدلهای خود اعمال کردهاند.

به جای ساخت مدلهای هوش مصنوعی بدون این تدابیر، که پرهزینه، زمانبر و دشوار است، خلافکاران به یک روند جدید روی آوردهاند: خدمات جیل بریک.

بیشتر مدلهای هوش مصنوعی قوانین خاصی در مورد نحوه استفاده از آنها دارند. جیل بریک کردن به کاربران اجازه میدهد سیستم هوش مصنوعی را برای تولید خروجیهایی که این قوانین را نقض میکنند، دستکاری کنند .

به عنوان مثال، نوشتن کد برای باج افزار یا تولید متنی که میتواند در ایمیلهای کلاه برداری استفاده شود.خدماتی مانند EscapeGPT و BlackhatGPT دسترسی ناشناس به APIهای مدلهای زبانی و پیشنهادات جیل بریک که به طور مداوم به روز میشوند را ارائه میدهند.

برای مقابله با این صنعت رو به رشد، شرکتهای هوش مصنوعی مانند OpenAI و Google باید به طور مداوم حفرههای امنیتی را که میتوانند به سوءاستفاده از مدلهای آنها منجر شوند، پر کنند.

خدمات جیل بریک از ترفندهای مختلفی برای شکستن مکانیسمهای ایمنی استفاده میکنند، مانند پرسیدن سوالات فرضی یا پرسیدن سوالات به زبانهای خارجی. بین شرکتهای هوش مصنوعی که سعی در جلوگیری از بدرفتاری مدلهای خود دارند و افراد بدخواهی که همواره پیشنهادات خلاقانه تری برای جیل بریک ارائه میدهند، یک بازی مداوم گربه و موش وجود دارد.

جیل بریک یک خدمت فوق العاده جالب برای خلافکاران است.

داکسینگ (Doxing) و نظارت : استفاده از مدلهای زبانی هوش مصنوعی برای داکسینگ و نظارت

مدلهای زبانی هوش مصنوعی نه تنها ابزار مناسبی برای فیشینگ بلکه برای Doxing (افشای اطلاعات خصوصی و شناسایی افراد به صورت آنلاین) هستند.

به این دلیل که مدلهای زبانی هوش مصنوعی بر روی مقادیر زیادی از دادههای اینترنتی، از جمله دادههای شخصی، آموزش دیدهاند و میتوانند حدس بزنند که مثلاً کسی ممکن است کجا باشد.

به عنوان مثال، شما میتوانید از یک چت بات بخواهید که تظاهر کند یک کارآگاه خصوصی با تجربه در پروفایل سازی است. سپس میتوانید از آن بخواهید که متنی را که قربانی نوشته است تحلیل کند و از سرنخهای کوچک در آن متن اطلاعات شخصی را استنتاج کند .

به عنوان مثال، سن آنها بر اساس زمانی که به دبیرستان رفتند، یا جایی که زندگی میکنند بر اساس نشانههایی که در مسیر رفت و آمدشان ذکر کردهاند. هرچه اطلاعات بیشتری درباره آنها در اینترنت وجود داشته باشد، آنها بیشتر در معرض شناسایی قرار میگیرند.

تیمی از محققان اواخر سال گذشته کشف کردند که مدلهای زبانی بزرگ، مانند GPT-4، Llama 2 و Claude، قادر به استنتاج اطلاعات حساس مانند قومیت، محل و شغل افراد تنها از گفتگوهای معمولی با یک چت بات هستند. در تئوری، هر کسی که به این مدلها دسترسی داشته باشد میتواند از آنها به این روش استفاده کند.

از زمان انتشار مقاله آنها، خدمات جدیدی که از این ویژگی مدلهای زبانی سوءاستفاده میکنند، ظهور کردهاند.

و اگر افراد عادی میتوانند ابزارهای نظارتی مانند این بسازند، احتمالاً عوامل دولتی سیستمهای بهتری دارند.

شرکتها باید در حفاظت از دادهها و امنیت سرمایه گذاری کنند و روی دفاعها کار کنند.

افزایش آگاهی افراد ضروری است. مردم باید دوباره درباره آنچه آنلاین به اشتراک میگذارند فکر کنند و تصمیم بگیرند که آیا با استفاده از جزئیات شخصی شان در مدلهای زبانی راحت هستند یا نه.

نتیجه گیری

این موارد تنها بخشی از چالشهای امنیتی ناشی از استفاده خلافکاران از هوش مصنوعی در فعالیتهای غیرقانونی است. هوش مصنوعی مولد، ابزارهای قدرتمندی در اختیار خلافکاران قرار داده است.

آگاهی و احتیاط میتواند به محافظت از اطلاعات شخصی و جلوگیری از قربانی شدن کمک کند. شرکتها نیز باید به طور مداوم بر روی امنیت دادهها و سیستمهای خود سرمایه گذاری کنند تا از سوء استفادههای احتمالی جلوگیری کنند.