مدل MiniMax-M2 بهعنوان یک مدل زبان بزرگ متن باز (open-weight LLM) با مجوز MIT وارد عرصه شده و بهویژه در زمینهٔ “مدیریت خودکار ابزارها با عاملهای هوش مصنوعی” (agentic tool use) عملکردی عالی نسبت به بسیاری از رقبا نشان داده است. این مدل، ترکیبی از معماری Mixture-of-Experts و قابلیت استقرار کارآمد برای سازمانها را با قیمتی رقابتی ارائه میدهد. در این مقاله، نکات برجسته مربوط به MiniMax-M2 را بررسی میکنیم تا دریابید چرا این مدل میتواند گام مهمی در تحول هوش مصنوعی متن باز و سازمانی باشد.

چرا MiniMax-M2 در مرکز توجه است؟

مدل MiniMax-M2 تحت مجوز MIT عرضه شده است که به توسعه دهندگان و شرکتها اجازه میدهد بدون محدودیت تجاری آن را به کار گیرند و بازآموزی کنند. این ویژگی، آن را از بسیاری مدلهای اختصاصی متمایز میکند و دسترسی آزاد به وزنهای مدل (open-weight) را برای جامعهٔ هوش مصنوعی فراهم مینماید.

همچنین، امکان تطبیق با استانداردهای API نظیر OpenAI API و Anthropic API فراهم شده است، به طوری که مهاجرت از مدلهای اختصاصی به MiniMax-M2 سادهتر شده است.

عملکرد برتر در کاربرد ایجنت های هوش مصنوعی در ابزارها (Agentic Tool Use)

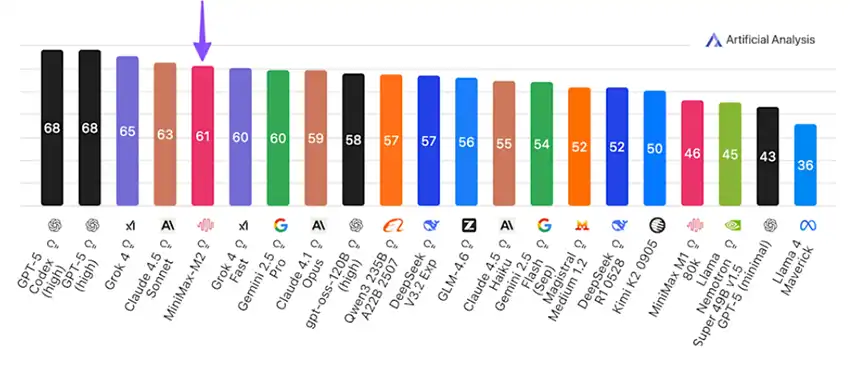

یکی از شاخصهای مهم عملکرد در LLMها، توانایی مدل در استفاده از ابزارها، برنامه ریزی و اجرای وظایف است. MiniMax-M2 در ارزیابی سازمان Artificial Analysis در شاخصهای agentic، کدنویسی و استدلال رتبهٔ نخست مدلهای متن-باز را کسب کرده است. برای مثال، در بنچمارک τ²-Bench امتیاز ۷۷.۲ را کسب کرده است که به عملکرد GPT‑۵ نزدیک است.

معماری Mixture-of-Experts و مقرون به صرفگی در زیرساخت

MiniMax-M2 از معماری Mixture-of-Experts (MoE) بهره میبرد و دارای ۲۳۰ میلیارد پارامتر کل است، اما تنها ۱۰ میلیارد پارامتر در هر بار استنتاج فعال میشوند. این طراحی باعث کاهش هزینه و سرعت بالاتر استنتاج شده و شرکتها میتوانند با چهار واحد GPU مانند NVIDIA H100 آن را راهاندازی کنند. این نکته برای استقرار در GPUهای تجاری یا edge/enterprise اهمیت دارد.

مقایسه با مدلهای اختصاصی و متن باز

با کسب امتیاز ۶۱ در شاخص هوش Artificial Analysis، مدل MiniMax-M2 بهترین مدل متن-باز شناخته شده است و عملکردی نزدیک به مدلهای اختصاصی مانند GPT-5 دارد. این موضوع اهمیت ویژهای برای شرکتهایی دارد که به دنبال جایگزینی مدلهای اختصاصی با گزینههای متن-باز هستند.

کاربردهای سازمانی و آینده استقرار

مدل MiniMax-M2 به طور ویژه برای جریانهای کاری توسعه دهندگان و سیستمهای Agent طراحی شده است؛ شامل ویرایش کد، تست خودکار، اجرای APIها، مرور وب و فرمانهای خطی. از سوی دیگر، قیمت استفاده از API آن تقریباً ۰.۳۰ دلار برای هر میلیون توکن ورودی و ۱.۲۰ دلار برای هر میلیون توکن خروجی است، یعنی صرفه جویی قابل توجه نسبت به گزینههای اختصاصی.

نکات برجسته و تحلیل

- مجوز MIT و وزنهای آزاد MiniMax-M2 :گام مهمی در توسعهٔ مدلهای متن-باز به سمت کاربرد سازمانی برداشته است.

- برتری در بنچمارکهای به کارگیری هوش مصنوعی در مدیریت ابزارها: این مدل میتواند به برنامهها و سرویسهایی تبدیل شود که فقط پاسخ نمیدهند، بلکه عمل میکنند.

- معماری مقرون به صرفه: با فعال سازی بخش کوچکی از پارامترها، هزینه و انرژی استنتاج کاهش یافته و دسترسی سازمانها به این گزینه سهولت یافته است.

- جایگزین عملی برای مدلهای اختصاصی: شرکتها میتوانند به جای پرداخت هزینههای سنگین و وابستگی به یک ارائه دهنده، از گزینهای متن باز با عملکرد بالا بهره ببرند.

- پیام به صنعت: این عرضه نشان میدهد که رقابت در مدلهای زبان بزرگ فقط در اندازه پارامتر نیست؛ کارایی ایجنت محور، استنتاج معنادار و قابلیت استقرار نیز مهم است.

نتیجهگیری

مدل متن باز MiniMax-M2 تنها یک مدل زبان بزرگ متن-باز نیست، بلکه نقطهٔ عطفی برای کاربردهای سازمانی و توسعه دهندگان در حوزهٔ « مدیریت خودکار ابزارها با عاملهای هوش مصنوعی» به شمار میرود. اگر سازمان شما به دنبال ارتقای جریانهای کاری هوش مصنوعی، کاهش هزینههای زیرساخت و بهرهگیری از مدلهای متن-باز با عملکرد برتر هست، اکنون زمان بررسی MiniMax-M2 است. برای کسب اطلاعات بیشتر و شروع، به منابع رسمی این مدل مراجعه کنید و آزمایشهای خود را آغاز کنید.