شرکتهای Together AI و Agentica از مدل جدید خود به نام DeepCoder-14B رونمایی کردند؛ مدلی قدرتمند در زمینه هوش مصنوعی کدنویسی که قابلیت رقابت با مدلهایی مانند o3-mini از OpenAI را دارد، اما در حجمی بسیار کمتر.

این مدل بر پایهی معماری DeepSeek-R1 توسعه یافته است و به توسعهدهندگان امکان تولید کد دقیق، انجام تحلیلهای منطقی پیشرفته و اجرای سریع در پروژههای واقعی را میدهد. همچنین، تمام اجزای آن از جمله دادههای آموزشی، کد منبع و گزارشهای فنی به صورت متن باز در اختیار عموم قرار دارد.

عملکرد سطح بالا با ساختاری کوچکتر

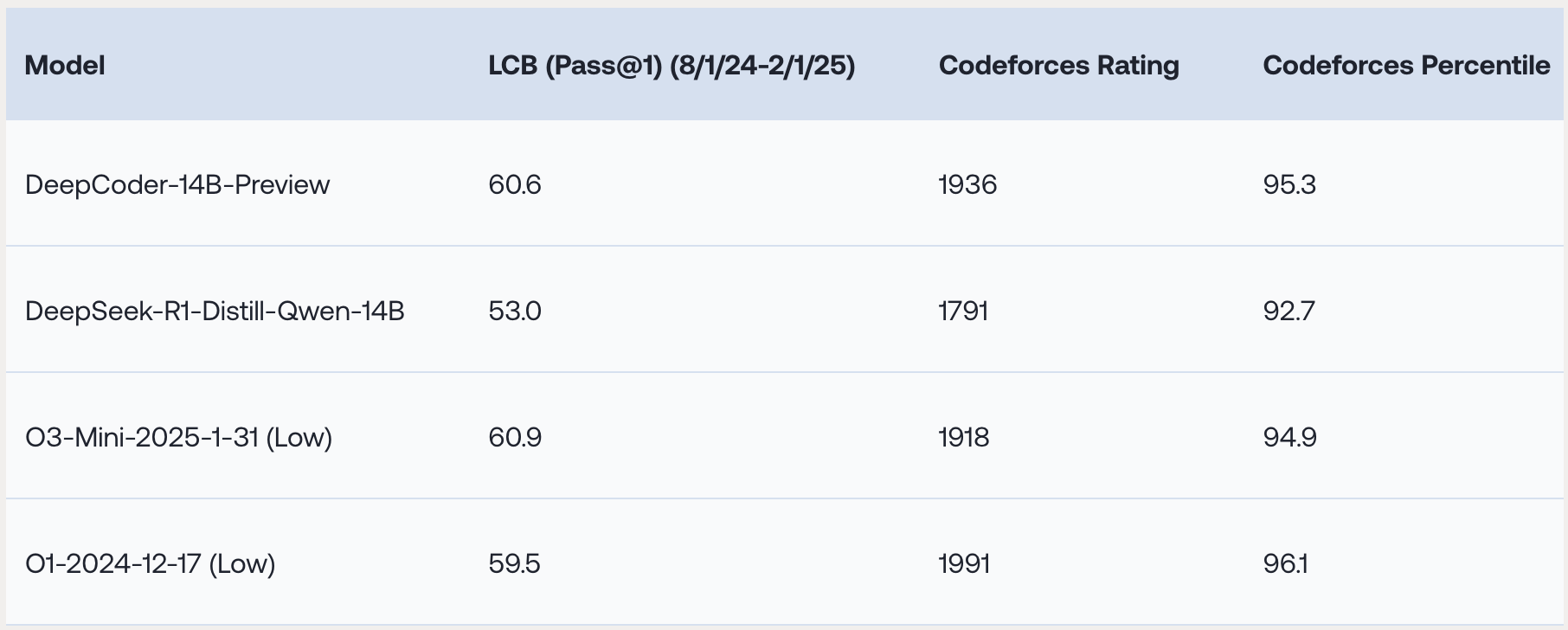

DeepCoder-14B در ارزیابیهای معتبر کدنویسی از جمله LiveCodeBench (LCB)، Codeforces و HumanEval+ عملکرد درخشانی ارائه داده است. این مدل:

نتایجی مشابه با مدلهای پیشرفته مانند o3-mini و o1 کسب کرده است

در آزمون AIME 2024 توانسته امتیاز ۷۳.۸٪ بهدست آورد

تنها با ۱۴ میلیارد پارامتر، بهرهوری بالایی در مقابل مدلهای حجیمتر نشان میدهد

این ترکیب از حجم کم و دقت بالا، آن را به انتخابی مناسب برای توسعهدهندگان و سازمانها تبدیل کرده است.

مطالب مرتبط : GAIA : استاندارد جدید سنجش هوش مصنوعی

نوآوریهای فنی در توسعه DeepCoder-14B

دادههای آموزشی پالایش شده و هدفمند

برای تقویت یادگیری تقویتی، پژوهشگران بیش از ۲۴,۰۰۰ مسئله با کیفیت را گردآوری و بر اساس اعتبار و پیچیدگی پالایش کردند. این رویکرد باعث شد مدل به جای تکرار پاسخها، واقعاً به حل مسائل جدید مسلط شود.

سیستم پاداش دقیق با تأکید بر اجرای موفق

مدل تنها در صورتی پاداش میگیرد که کدی بنویسد که تستهای واحد را با موفقیت پشت سر بگذارد. این رویکرد کمک کرده تمرکز بر کیفیت اجرا حفظ شود و مدل از روشهای غیرواقعی مانند حفظ پاسخهای عمومی اجتناب کند.

بهینه سازی آموزش در توالیهای طولانی

با تکیه بر الگوریتم Group Relative Policy Optimization (GRPO) و اعمال بهینه سازیهای متعدد، پژوهشگران توانستند پایداری آموزش را افزایش دهند. فرآیند یادگیری با توالیهای کوتاه آغاز شد و سپس طول محتوا به تدریج افزایش یافت. این مدل اکنون قادر است ورودیهایی با ظرفیت تا ۶۴K توکن را پردازش کند و مسائل پیچیدهتری را حل نماید.

تکنیکهای کلیدی:

استفاده از فیلتر تطبیقی طول محتوا برای جلوگیری از جریمه هنگام پردازش توالیهای بلند

سازگاری تدریجی با محتوای پیچیدهتر برای افزایش دقت و پایداری

افزایش دو برابری سرعت آموزش با One-Off Pipelining

یکی از بزرگترین چالشها در آموزش مدلهای کدنویسی، سرعت پایین نمونه گیری است که کارایی پردازندههای گرافیکی را کاهش میدهد. تیم توسعه با پیادهسازی مکانیزم One-Off Pipelining توانست این مشکل را برطرف کند.

✅ نتیجه: سرعت آموزش برای وظایف کدنویسی دو برابر شد

✅ مدت زمان آموزش کامل مدل: تنها ۲.۵ هفته با استفاده از ۳۲ پردازنده H100

آینده روشن برای توسعهدهندگان و کسبوکارها

هم اکنون همه اجزای DeepCoder-14B از جمله کد منبع، دادهها و ابزارهای موردنیاز به صورت رایگان در GitHub و Hugging Face در دسترس قرار دارند. این دسترسی آزاد:

سازمانها را از پرداخت هزینههای سنگین برای مدلهای اختصاصی بینیاز میکند

باعث افزایش رقابت، نوآوری و کاهش هزینه ورود به حوزهی هوش مصنوعی میشود

نتیجه گیری: حرکت به سوی هوش مصنوعی باز و قابل دسترس

DeepCoder-14B تنها یک مدل جدید کدنویسی نیست؛ بلکه نشان دهندهی تحولی اساسی در مسیر توسعه مدلهای هوش مصنوعی متن باز و بهینه است. اکنون هوش مصنوعی با دسترسی آسان، بهرهوری بالا و ساختار سبک، در دسترس همگان قرار دارد.

📌 بهنظر شما آیا توسعه مدلهای قدرتمند اما متنباز میتواند آینده فناوری را متحول کند؟