الگوریتم DenseAV که در دانشگاه MIT توسعه یافته است، با تماشای ویدیوهای افراد صحبت کننده، توانایی تجزیه و تحلیل زبان را به دست میآورد. این الگوریتم با ترکیب سیگنالهای صوتی و تصویری، میتواند معنای کلمات را پیشبینی کند.

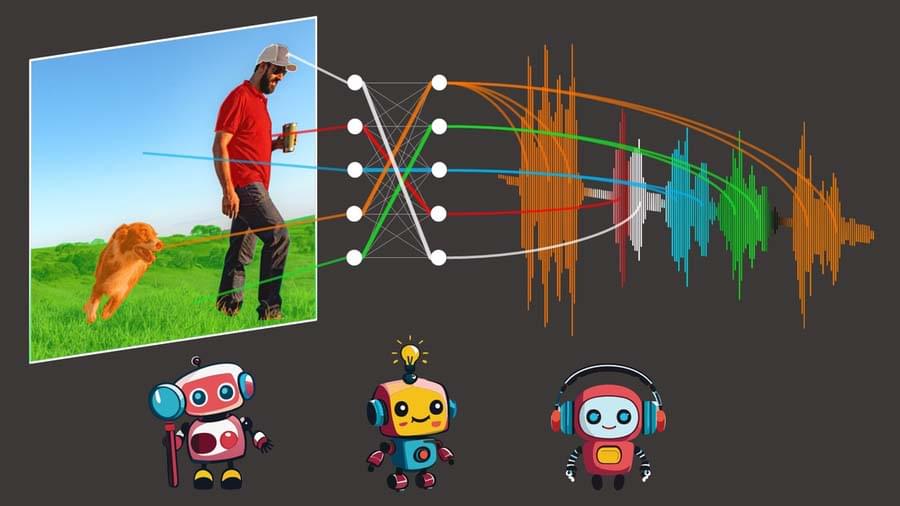

الگوریتم DenseAV به منظور یادگیری زبان، از پیش بینی محتوای تصویری بر اساس محتوای صوتی و برعکس استفاده می کند. به عنوان مثال، اگر صدایی را بشنوید که می گوید :”کیک را در دمای ۳۵۰ درجه فارنهایت پختهاند”، پیکسلهای مرتبط با کیک یا فر در تصویر را تشخیص می دهد.

هنگامی که محققان DenseAV را در این بازی تطبیقی اموزش دادند، بررسی کردند که مدل هنگام شنیدن صدا به دنبال کدام پیکسل است. به عنوان مثال، هنگامی که کسی می گوید “سگ”، الگوریتم بلافاصله شروع به جستجوی سگ ها در جریان ویدئو می کند. با دیدن پیکسل هایی که توسط الگوریتم انتخاب می شوند، می توان کشف کرد که الگوریتم فکر می کند یک کلمه به چه معنی است.

محققان میخواستند بدانند آیا الگوریتم تفاوت بین کلمه “سگ” و “صدای سگ ” را میداند یا خیر. بنابراین تیم با ایجاد یک “مغز دو طرفه” برای DenseAV این موضوع را بررسی کرد. آنها متوجه شدند که یک طرف مغز DenseAV به طور طبیعی بر روی زبان تمرکز دارد، مانند کلمه “سگ”، و طرف دیگر بر روی صداها مانند “صدای سگ” متمرکز است. این نشان میدهد که DenseAV نه تنها معنای کلمات و مکانهای صداها را یاد گرفته است، بلکه می تواند بین این نوع ارتباطات، بدون دخالت انسانی یا دانش زبان نوشتاری، تمایز قائل شود.

چالش های DenseAV

یک چالش قدرتمند در پیش روی تیم، یادگیری زبان بدون هیچ متن ورودی است. هدف آنها از این تلاش، کشف معنای زبان از نقطهی صفر است، بدون استفاده از مدلهای زبان پیشآموز. این رویکرد از نحوهی یادگیری کودکان الهام گرفته شده است، که با مشاهده و گوش دادن به محیط خود، زبان را میآموزند. برای دستیابی به این هدف، DenseAV از دو مولفهی اصلی برای پردازش دادههای صوتی و تصویری به صورت جداگانه استفاده می کند.

این جداسازی باعث میشود الگوریتم نتواند تقلب کند، زیرا اجازه نمیدهد تا بخش تصویری به بخش صوتی نگاه کند و بالعکس. این روش باعث میشود الگوریتم اشیاء را تشخیص داده و ویژگیهای دقیق و معناداری را برای هر دو سیگنال صوتی و تصویری ایجاد کند. DenseAV با مقایسه سیگنالهای صوتی و تصویری، مشخص میکند کدام سیگنالها مطابقت دارند و کدام سیگنالها مطابقت ندارند. این روش، به نام یادگیری متقابل، نیازی به نمونههای برچسبگذاری شده ندارد و اجازه میدهد تا DenseAV الگوهای پیش بینی مهم زبان را خودش کشف کند.

الگوریتم DenseAV از دو مولفه برای پردازش جداگانه دادههای صوتی و تصویری استفاده میکند. این طراحی به الگوریتم امکان تشخیص اشیاء و تولید ویژگیهای دقیق و معنادار برای سیگنالهای صوتی و تصویری را می دهد.

شناسایی و تقسیمبندی اشیاء در تصاویر، همچنین صداهای محیطی و کلمات گفته شده در صداهای رکورد شده، هر کدام مشکلات دشواری در خود دارند. مدل DenseAV پیشرفتهای قابل توجهی در توسعه روشهایی که میتوانند به طور همزمان این وظایف را حل کنند، داشته است.

همچنین انتقال به یک معماری ترانسفورماتور بزرگ چالشهایی را ایجاد کرد، زیرا این مدلها ممکن است جزئیات ریز را به راحتی نادیده بگیرند. تشویق مدل به تمرکز بر این جزئیات، یک مشکل مهم بود.

تفاوت الگوریتم DenseAV و سایر الگوریتم های مشابه

یکی از تفاوتهای اصلی بین الگوریتم DenseAV و الگوریتم های مشابه این است که الگوریتمهای قبلی تمرکز خود را بر مفهوم تشابه بین صدا و تصویر می گذارند. به عبارت دیگر، یک کلیپ صوتی کامل مانند جمله “سگ روی چمن نشست” به یک تصویر کامل از یک سگ نسبت داده میشود. روشهای قبلی نمی توانند جزئیات دقیقتری را مشاهده کنند، مانند ارتباط بین کلمه “چمن” و “چمن زیر سگ”. الگوریتم DenseAV به دنبال تمام تطابقهای ممکن بین کلیپ صوتی و پیکسلهای تصویر است و این باعث بهبود عملکرد و دقیقتر شدن مکانیابی صداها میشود.

محققان، DenseAV را بر روی مجموعه داده AudioSet آموزش دادند که شامل ۲ میلیون ویدیوی YouTube است. آنها همچنین مجموعههای داده جدیدی ایجاد کردند تا عملکرد مدل در ارتباط بین صداها و تصاویر را آزمایش کنند. در این آزمایشها، DenseAV در وظایفی مانند شناسایی اشیاء از نامها و صداها، عملکرد بهتری نسبت به مدلهای مشابه دیگر داشت.

مجموعههای داده قبلی، فقط قدر به ارزیابیهای کلی و سطحی بودند. در مدل جدید، یک مجموعه با استفاده از مجموعه داده های تقسیم بندی معنایی ایجاد شد. این باعث میشود که برچسب گذاری دقیق تری انجام شود تا عملکرد مدل به دقت ارزیابی شود. محققان می توانند الگوریتم را با صداها یا تصاویر خاص فراخوانی کنند و موقعیتهای دقیق آنها را دریافت کنند.

اهداف DenseAV

هدف تیم در آینده این است که سیستمهایی ایجاد کنند که می تواند از حجم زیادی از دادههای صوتی یا تصویری یاد بگیرند. این سیستم ها برای حوزه های جدید که در ان تعداد زیادی از هر دو حالت صدا و تصویر وجود دارد، بسیار مهم است. مثلا یادگیری از ویدیوهای منتشر شده در اینترنت به مقیاس بزرگ.

همچنین هدف محققان افزایش اندازه این سیستمها در مقیاس های بزرگتر و ادغام دانش از مدلهای زبانی برای بهبود عملکرد است.

این مدل فرضیهای در مورد زبان خاصی که در حال گفتن است، ندارد و در نتیجه در اصل میتواند از دادهها در هر زبانی یاد بگیرد. جالب است که ببینیم با افزایش مقیاس به هزاران یا میلیونها ساعت دادهی ویدیویی در طول چندین زبان مختلف، DenseAV چه چیزی یاد میگیرد.

مارک همیلتون، دانشجوی دکتری دانشگاه MIT، قصد دارد از طریق ماشینها چگونگی ارتباط حیوانات را درک کند. برای این منظور، او ابتدا سیستمی را ایجاد کند که بتواند زبان انسان را “از ابتدا” یاد بگیرد. در واقع از صدا و تصویر برای یادگیری زبان استفاده کند. بنابراین DenseAV می تواند در دستیابی به این هدف موثر باشد.

همچنین، یک کاربرد جذاب دیگر، درک زبانهای جدید مانند زبان ارتباطی دلفینها یا نهنگها است که شکل نوشتاری ارتباطی ندارند.

محققان امیدوارند که DenseAV بتواند به آنها کمک کند تا این زبانها را، که از آغاز تاکنون انسان ها موفق به ترجمه آنها نشده اند، درک کنند. در نهایت، امیدواریم که این روش بتواند الگوها بین دیگر جفتهای سیگنالها را نیز کشف کند، مانند صداهای لرزشی که زمین تولید میکند و زمین شناسی آن .

در نهایت این الگوریتم دارای کاربردهای مختلفی در جستجوی چند رسانهای، یادگیری زبان و رباتیک خواهد داشت.