در دنیای پر رقابت هوش مصنوعی، استارتاپ چینی DeepSeek با معرفی مدل استدلالی جدید خود به نام DeepSeek R1، توجه جامعه جهانی را به خود جلب کرده است. این مدل که ادعا میکند در برخی شاخصهای کلیدی عملکردی مشابه یا حتی بهتر از ChatGPT شرکت OpenAI دارد، با هزینهای به مراتب...

اخبار

پنج تهدید مهم بدافزار در سال ۲۰۲۵ که باید با آنها مقابله کنید

در سالهای اخیر، تحولات فناوری و افزایش وابستگی به فضای دیجیتال، چالشهای امنیتی بیسابقهای را به همراه آورده است. با پیشرفت هوش مصنوعی و فناوریهای نوظهور، بدافزارها نیز به شکل پیچیدهتر و مخربتری در حال تکامل هستند. پیشبینی میشود که در سال ۲۰۲۵، سازمانها و...

Nvidia در CES 2025 : دستاوردهای جدید در زمینه AI فیزیکی و بهینه سازی صنعت

در نمایشگاه CES امسال، Nvidia مجموعهای از اخبار و دستاوردهای خود را در حوزه HPC-AI معرفی کرد. در اینجا مروری بر مهمترین اعلانهای این شرکت در این زمینه داریم: "Mega" فریم ورک جدید Omniverse برای شبیه سازی رباتهای صنعتی Nvidia از "Mega" به عنوان فریم ورک...

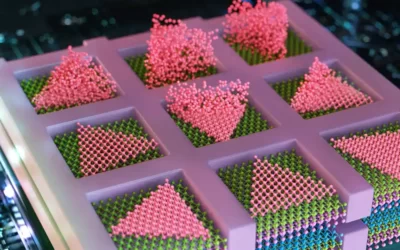

تراشه های سه بعدی: راه حلی انقلابی برای افزایش قدرت پردازش و کارایی هوش مصنوعی

در دنیای فناوری، پیشرفتهای چشمگیر در زمینهی تراشه های سه بعدی (3D Chips)، در حال باز تعریف مرزهای قدرت پردازش و کارایی سخت افزارها هستند. با نزدیک شدن صنعت الکترونیک به محدودیتهای فیزیکی در کوچک سازی ترانزیستورها، محققان به دنبال راه حلهای نوآورانهای هستند...

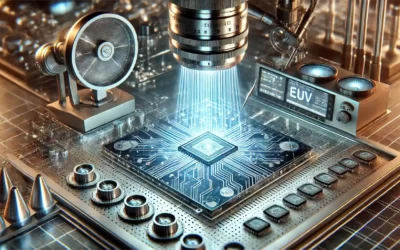

پیشرفت لیتوگرافی EUV برای صنعت نیمه هادیها

موسسه ملی آزمایشگاه لارنس لیورمور (LLNL) اخیراً از آغاز یک پروژه تحقیقاتی چهار ساله به ارزش ۱۲ میلیون دلار خبر داده است که هدف آن بهبود فناوری لیتوگرافی فرابنفش شدید (Extreme Ultraviolet lithography EUV) است. این پروژه با همکاری محققان از موسسات مختلف از جمله SLAC...

روش Bad Likert Judge و تهدید امنیت مدلهای زبانی

پژوهشگران امنیت سایبری از یک تکنیک جدید پرده برداشتهاند که میتواند محدودیتهای ایمنی مدلهای زبانی بزرگ (LLM) را دور بزند و پاسخهای بالقوه خطرناک یا مخرب تولید کند. این روش که به «Bad Likert Judge» معروف شده است، توسط تیم Unit 42 شرکت Palo Alto Networks شناسایی...

قدرتمندترین ابررایانه جهان برای شبیه سازی انفجارهای هستهای ساخته شد

ابررایانه جدید "ال کاپیتان " (El Capitan) که در آزمایشگاه ملی لارنس لیورمور در کالیفرنیا (LLNL) ساخته شده، اکنون عنوان سریعترین ابررایانه جهان را به خود اختصاص داده است. این سیستم پیشرفته برای پشتیبانی از بازدارندگی هستهای ایالات متحده طراحی شده است. "ال کاپیتان"...

ایسوس از راهکارهای جدید ذخیره سازی و سرور برای هوش مصنوعی رونمایی کرد

شرکت ایسوس ، از نسل جدید زیرساختهای سروری و ذخیرهسازی خود رونمایی کرد. این راهکارها شامل سرورهای قدرتمند با پردازندههای AMD و Intel و همچنین سیستمهای خنککننده مایع است که برای تسریع در پردازشهای هوش مصنوعی طراحی شدهاند. سرورهای هوش مصنوعی ایسوس، با ارائه...

رشد پایگاه داده برداری با ظهور GenAI و مدلهای زبان بزرگ

رشد پایگاه داده برداری ، با ورود استارتاپهای جدید به این حوزه و سرمایه گذارانی که به دنبال سهمی از این بازار جذاب هستند، به سرعت در حال گسترش است. گسترش مدلهای زبان بزرگ (LLMs) و هوش مصنوعی مولد (GenAI) بستری مناسب برای رشد فناوریهای مرتبط با پایگاههای داده...

تأثیر هوش مصنوعی مولد در خرده فروشی آمازون

هوش مصنوعی مولد در خرده فروشی تأثیر چشمگیری داشته است و آمازون یکی از پیشروان این تحول است. وب سایت Chain Store Age اخیراً با جاستین هونامان، رئیس بازاریابی جهانی خرده فروشی و کالاهای مصرفی در Amazon Web Services، درباره چگونگی تغییر عملیات خرده فروشی به کمک هوش...